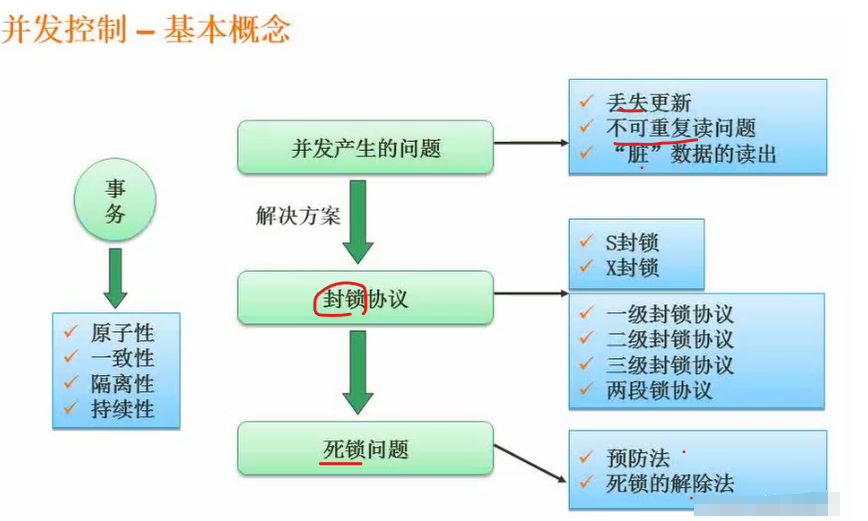

数据库并发控制(Database Concurrency Control):确保数据一致性和系统稳定性的关键机制

数据库并发控制(Database Concurrency Control)是数据库管理系统(DBMS)中的一个核心概念,它旨在确保在多个用户或事务同时访问数据库时,数据的一致性和隔离性得到维护。下面将详细解释这一软件开发词汇,并通过一个实例进行形象讲解。一、数据库并发控制的定义数据库并发控制是指管理多个事务同时访问同一数据库时的数据一致性和完整性,以防止数据冲突和不一致。在数据库系统中,并发控制机