一、LangChain基础概念与核心价值

LangChain是一个开源的Python框架,专为基于大语言模型(LLM)的应用开发而设计。其核心目标是通过模块化设计,将LLM与外部数据源、工具和服务无缝集成,构建具备上下文感知、多步骤推理和复杂业务逻辑处理能力的智能应用。其核心价值体现在以下方面:

- 降低技术门槛:提供标准化接口和抽象组件,开发者无需深入了解底层模型细节即可快速构建应用。

- 增强模型能力:通过RAG(检索增强生成)、多智能体协作等技术,突破模型参数限制,提升生成质量。

- 简化开发流程:从数据加载、向量存储到模型推理,提供端到端工具链,支持从原型到生产的全生命周期管理。

二、LangChain技术架构与核心模块

(一)分层架构设计

LangChain采用分层架构,分为接口层、逻辑层和数据层:

- 接口层:统一对接OpenAI、DeepSeek-R1等主流LLM API,支持动态模型切换。

- 逻辑层:通过Chain(链)和Agent(代理)实现业务流程编排,支持条件判断、循环等复杂逻辑。

- 数据层:支持本地向量数据库(如FAISS)与云存储(如Pinecone)的混合部署,提供高效的数据检索能力。

(二)六大核心模块

- 模型I/O(Model I/O)

- LLM初始化:支持GPT-4、Claude等主流模型,通过配置

model_name参数快速切换模型供应商。 - 嵌入模型:提供文本向量化能力,支持高维向量压缩(如3072维降至1536维,保持90%准确率)。

- 代码示例:python

from langchain.llms import OpenAI llm = OpenAI(model_name="gpt-4-turbo-2025", temperature=0.7, max_tokens=2048)

- LLM初始化:支持GPT-4、Claude等主流模型,通过配置

- 链(Chains)

- 链式工作流:通过组合多个LLM调用或工具操作,构建复杂任务流。支持顺序链(SequentialChain)、条件链(ConditionalChain)等。

- 动态路由:根据上下文选择执行路径,例如在问答系统中优先调用知识库检索,失败时再调用LLM生成。

- 代码示例:python

- 记忆(Memory)

- 会话记忆:支持短期对话记忆(如滑动窗口算法优化长对话内存占用)和长期向量化存储(如用户偏好、历史行为)。

- 代码示例:python

from langchain.memory import ConversationBufferMemory memory = ConversationBufferMemory( memory_key="chat_history", return_messages=True, k=5 # 保留最近5轮对话 )

- 代理(Agents)

- 工具集成:支持将计算器、天气API等外部工具与LLM结合,实现多步骤任务执行。

- 优先级调度:根据工具响应延迟动态分配资源,例如优先调用低延迟的天气API,高延迟的复杂计算任务后处理。

- 代码示例:python

from langchain.agents import Tool calculator_tool = Tool( name="Calculator", func=math_processor, description="用于执行数学计算" ) weather_tool = Tool( name="WeatherAPI", func=get_weather_data, description="查询实时天气数据" )

- 数据连接(Data Connection)

- 文档处理流程:支持PDF、HTML等格式文档的加载、分块、向量化存储和检索。

- 向量数据库优化:通过FAISS等工具实现相似性检索,支持最大边际相关性(MMR)算法提升结果质量。

- 代码示例:python

from langchain.document_loaders import PyPDFLoader from langchain.text_splitter import RecursiveCharacterTextSplitter from langchain.vectorstores import FAISS loader = PyPDFLoader("technical_manual.pdf") documents = loader.load() text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=200) docs = text_splitter.split_documents(documents) vectorstore = FAISS.from_documents(documents=docs, embedding=OpenAIEmbeddings()) retriever = vectorstore.as_retriever(search_type="mmr", search_kwargs={"k": 5})

- 回调(Callbacks)

- 全链路监控:捕获Token消耗、响应延迟等关键指标,支持日志记录和性能分析。

- 代码示例:python

from langchain.callbacks import FileCallbackHandler handler = FileCallbackHandler('llm_logs.json') chain.run(input, callbacks=[handler])

三、LangChain应用场景与案例分析

(一)智能文档问答系统

场景描述:构建基于企业私有文档库的智能问答系统,支持用户自然语言提问并返回精准答案。

技术实现:

- 数据预处理:使用

PyPDFLoader加载PDF文档,通过RecursiveCharacterTextSplitter分块。 - 向量存储:将分块后的文档向量化并存储到FAISS数据库。

- 问答链构建:通过

RetrievalQA链实现检索增强生成,支持返回原始文档片段。

代码示例:

pythonfrom langchain.chains import RetrievalQA qa_chain = RetrievalQA.from_chain_type( llm=llm, chain_type="stuff", retriever=retriever, return_source_documents=True )

(二)多智能体协作的自动化客服

场景描述:在电商场景中,构建由多个智能体协作的客服系统,支持订单查询、售后处理等复杂任务。

技术实现:

- 智能体分工:

- 订单查询智能体:调用订单系统API。

- 售后处理智能体:集成物流跟踪、退款计算等工具。

- 任务调度:通过

ZeroShotReactAgent实现智能体间的任务分配和协作。

(三)企业级RAG应用

场景描述:在金融领域,构建基于RAG的智能投研助手,支持实时检索市场数据、财报分析等。

技术实现:

- 数据源集成:连接Wind、Bloomberg等金融数据API。

- 检索优化:使用

ContextualCompressionRetriever过滤低质量文档。 - 生成增强:通过

StuffDocumentsChain将检索结果与用户问题合并输入LLM。

四、LangChain技术优势与行业影响

(一)技术优势

- 模块化与可扩展性:支持自定义组件集成,例如接入私有API或领域专用工具。

- 高性能与稳定性:支持批量处理、异步调用和并行化操作,内置回退机制保障服务可用性。

- 全生命周期管理:通过

LangSmith平台实现调试、测试、评估和监控。

(二)行业影响

- 推动AI应用落地:降低企业级LLM应用的开发成本,例如某银行通过LangChain将客服响应时间缩短60%。

- 促进开源生态繁荣:社区维护的第三方工具(如

langchain-community)支持快速集成Pinecone、FAISS等外部服务。 - 定义行业标准:LangChain已成为LLM应用开发的事实标准,其设计理念被Azure OpenAI、Google Vertex AI等平台借鉴。

五、LangChain未来发展趋势

- 多模态交互:支持图像、语音、文本等多模态输入输出,例如在医疗场景中结合CT影像和病历文本进行诊断。

- 边缘计算集成:通过模型压缩与量化技术,在资源受限设备上部署轻量级LangChain应用。

- 可信AI:开发可解释性工具,例如通过

Chain-of-Thought技术展示LLM的推理过程。

LangChain通过其模块化设计、强大的集成能力和全生命周期管理工具,已成为构建LLM应用的首选框架。随着技术的不断演进,LangChain将在更多领域推动AI技术的创新应用,为行业数字化转型提供核心支撑。

扫描下方二维码,一个老毕登免费为你解答更多软件开发疑问!

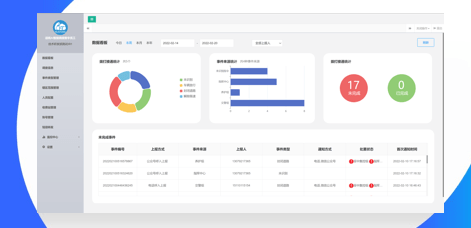

物业管理工单AI调度方案:维修响应缩短至30分钟的核心算法

物业报修总是慢半拍?业主群里天天吐槽维修不及时?物业管理人员为工单分配焦头烂额?别慌!今天给大家揭秘一套超实用的物业工单 AI 调度方案,手把手教你用核心算法把维修响应时间从几小时压缩到 30 分钟内,让业主满意度直线飙升!据中国物业管理协会发布的《2023 年物业管理行业发展报告》显示,在业主对物业的投诉中,维修响应不及时占比高达 38%。而当维修响应时间控制在 30 分钟以内时,业主对物业的

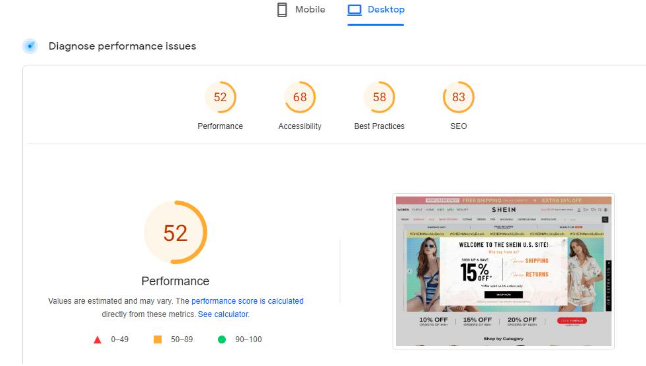

电商网站加速方案:WooCommerce加载从5s到0.9s的实操

你的 WooCommerce 电商网站是不是也总被用户吐槽 “加载慢如龟”?明明商品超有吸引力,却因为 5 秒的加载时间,白白流失了大量潜在客户!别慌!今天手把手教你把网站加载速度从 5 秒直接干到 0.9 秒,让你的店铺直接起飞!根据 Akamai 的研究报告显示,网页加载时间每延迟 1 秒,就会导致用户转化率下降 7%,销售额降低 11% ,用户跳出率增加 16%。想象一下,每天几百上千的访

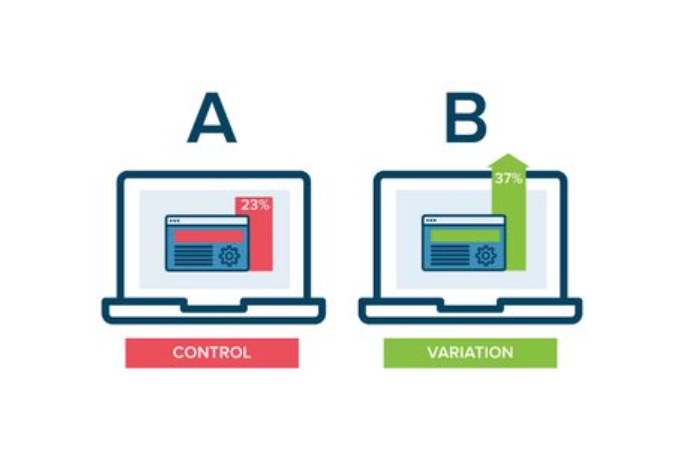

APP开发后如何做A/B测试? (转化率提升指南!界面/文案/按钮优化案例)

辛辛苦苦开发的 APP,转化率却总是上不去?根据麦肯锡发布的《2024 年移动应用用户行为报告》显示,经过科学 A/B 测试优化的 APP,平均转化率能提升 35%!想要让界面、文案、按钮成为转化 “利器”,A/B 测试绝对是必备技能。今天就通过真实案例,手把手教你用 A/B 测试提升 APP 转化率!一、为啥 A/B 测试是转化率的 “加速器”?用数据说话先看两组真实数据:某电商 APP 对商品

APP开发后如何做热更新? (动态修复BUG!不重新上架的更新方案)

APP 刚上线就发现严重 BUG,难道只能等重新上架 “干着急”?据 App Annie 发布的《2024 年移动应用质量报告》显示,因等待重新上架修复问题,平均每个 APP 会流失 12% 的用户。而热更新技术能让你绕过应用商店审核,动态修复 BUG!今天就手把手教你 APP 热更新的实现方案,让你的应用随时 “满血复活”。一、为啥热更新成了开发者的 “救命稻草”?先看一组真实数据:某热门游戏